Vor einigen Monaten sprach mich ein alter Geschäftskontakt und Freund auf diese Deepfakeproblematik an und ich fand endlich Gelegenheit, mir das Thema sehr genau anzuschauen. Wie ging ich hier vor? Die Antwort ist simpel: ich organisierte mir die Software „Automatic 1111“ inkl. aller relevanten Checkpoints (Daten) + Loras und generierte im ersten Schritt 50.000 Deepfakes. Hierbei wurde auf folgende Punkte geachtet:

- Generierung von Medien mit verschiedenen Qualitäten

- Promptaufbau auch mit Fokus auf Emotionen, Licht/Schatten-Effekte

- Generierung von Deepfakes mit Inhalt(en): alle Geschlechter, alle Altersgruppen, viele Millieu-Beispiele

Ich legte die besten Generierungen diversen Freund:innen zur Ansicht vor, um meine (!) Fehlinterpretationen zu bereinigen. Bei der Vorlage achtete ich sehr genau darauf, dass ich ausschließlich weibliche „normschöne“ Deepfakes (keine Aktfotografien) 2 Gruppen präsentierte:

- männlichen Freunden

- weiblichen Freunden

Hochspannend waren die Rückmeldungen aus der Gruppe (2) und ich hörte in vielen Gesprächen folgende Hinweise:

- „Da stimmt etwas nicht“

- „Die Personen haben keinen Charakter“

- „Die Personen haben keine Seele“

Die Gruppe (1) reagierte anders:

- „Wow“

- „Wo hast Du die Frau kennen gelernt?“

- …

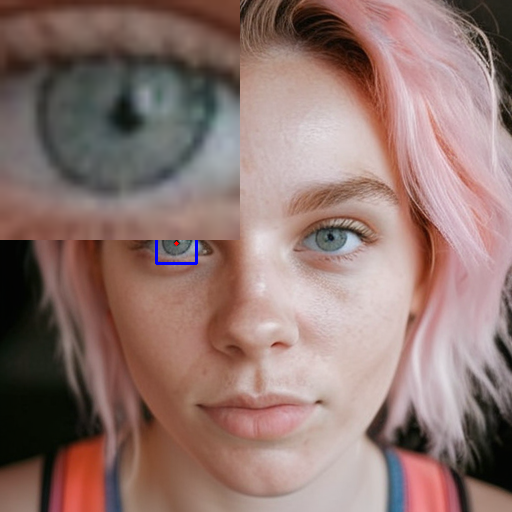

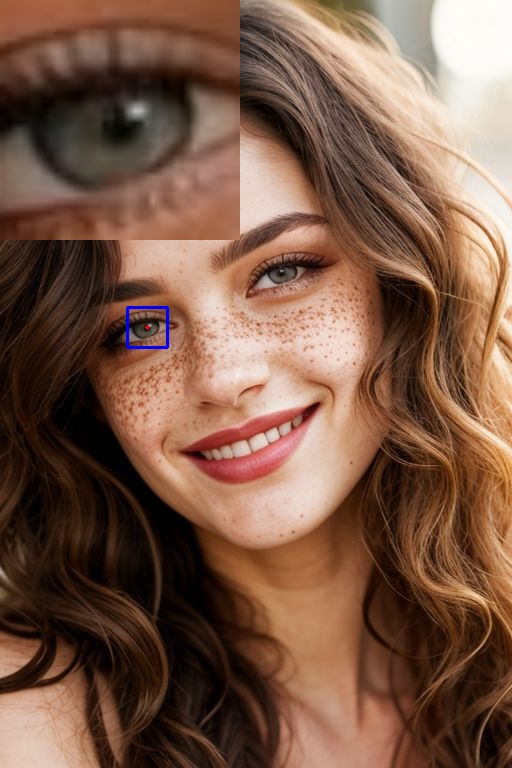

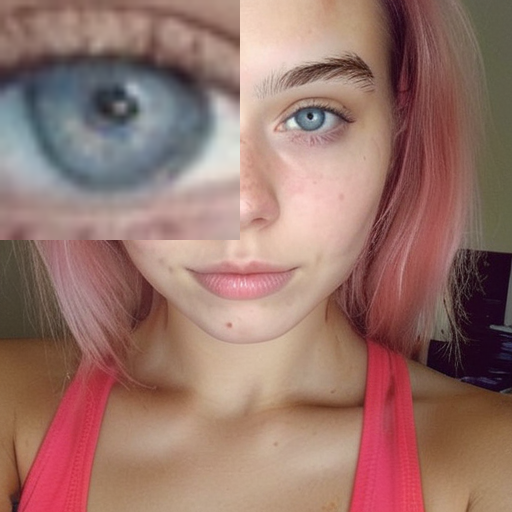

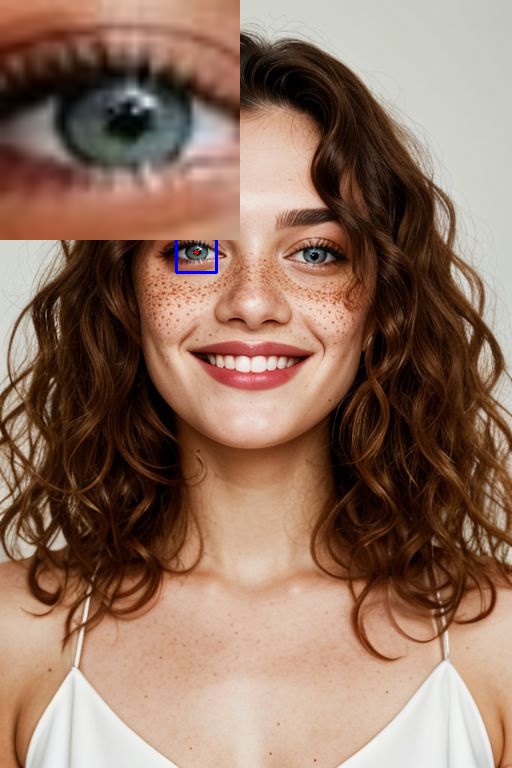

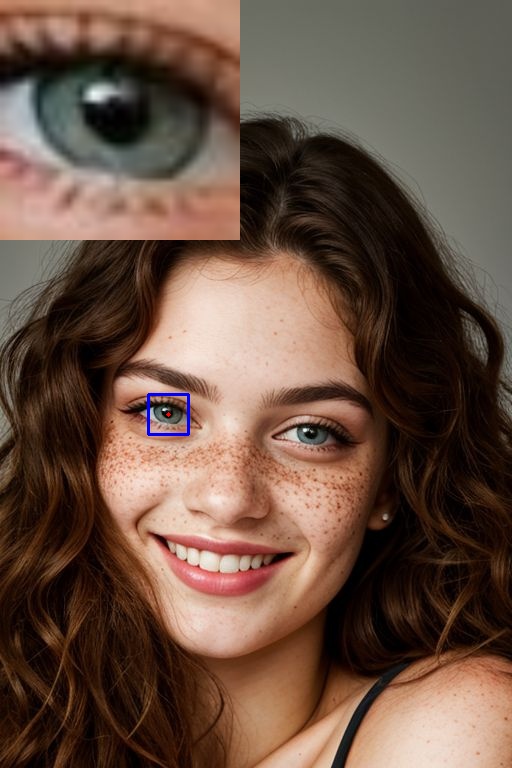

Eigentlich witzig, hier noch einmal über die Ergebnisse meiner kleinen und natürlich unprofessionell durchgeführten „Marktforschung“ nachzudenken. Allerdings entschied ich mich, mich mit der Aussage „Die Personen haben keine Seele“ etwas intensiver zu beschäftigen und da die Augen ja der „Spiegel der Seele“ sind, war die Problemlösung „Deepfakeerkennung“ schnell geregelt.

Alle geprüften Deepfakes aus dem Pool der 50.000-Bilder zeigen diese Deepfake-Indikatoren:

- Deformierte Iris + Pupille

- leichte und starke Abweichungen der Iris + Pupillengröße bei beiden Augen

- leichte und starke Fehldarstellungen der Irisgestaltung (Bezug: ein Auge, beide Augen)

In dem Umfeld der Bildgenerierung existieren selbstverständlich extrem gut trainierte Daten und auch Loras, welche das Problem der (fehlerhaften) Augendarstellung lösen können, jedoch sind auch in den relevanten Experimenten die genannten „Bugs“ aufgefallen.

Wie sieht nun unser Ansatz aus? Wir sammeln noch ca. 150.000 weitere Deepfakes, trainieren eine sehr spezielle KI und geben das Resultat (DIE Daten, DIE KI) Mitte 2024 einem potentiell interessierten Publikum frei.

Wie kann man nun Deepfakes OHNE tiefergehendes technisches Wissen und Daten erkennen? Meine Ratschläge sind:

- Wenn es sich „komisch anfühlt“, stimmt mit dem Medium etwas nicht.

- Wenn das Medium zu glatt und zu professionell ausschaut und die Gestaltung nicht in den Kontext und die Story passt, stimmt etwas mit dem Medium nicht.

- Immer auf die Verbindung der Motive (Vordergrund, Mittelgrund, Hintergrund) achten, hier lassen sich auch manchmal Unstimmigkeiten erkennen.

- Interessant sind auch Leberflecken, Narben an untypischen Stellen im Gesicht / auf der Haut

- Unstimmigkeiten bei Zähnen / Zahndarstellungen liefern Hinweise auf Deepfakes