Die aktuelle Datenbank umfasst die Ergebnisse aus 23575 Abfragen und speichert folgende Daten:

4.546.235 Beiträge

4.376.548 Tagwolken

2.031.490 codierte User

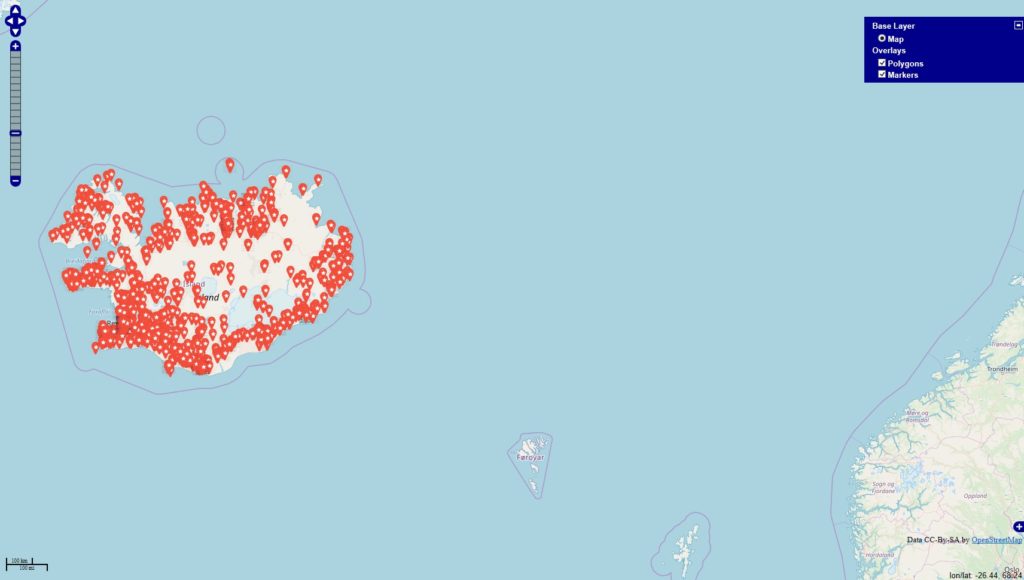

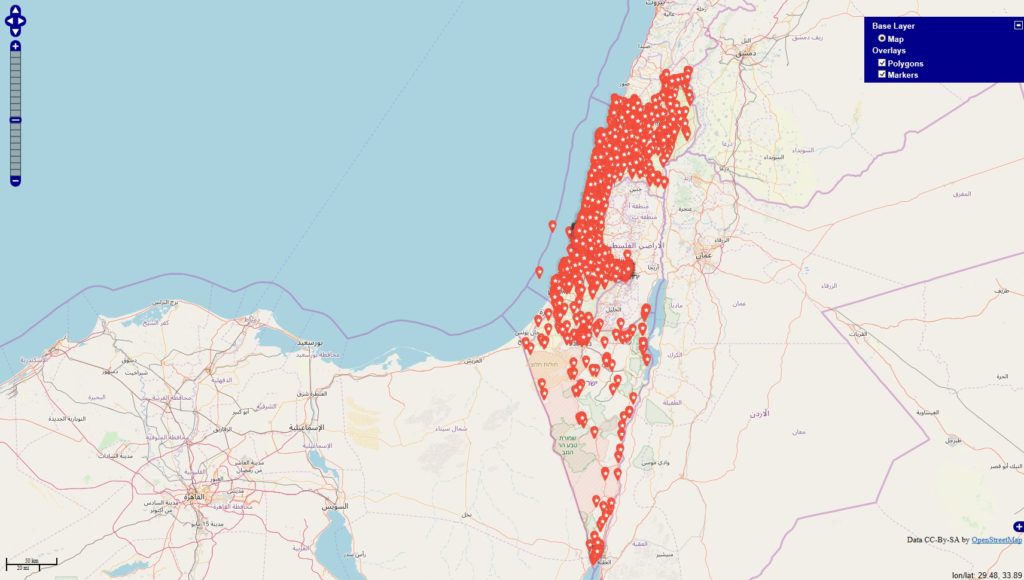

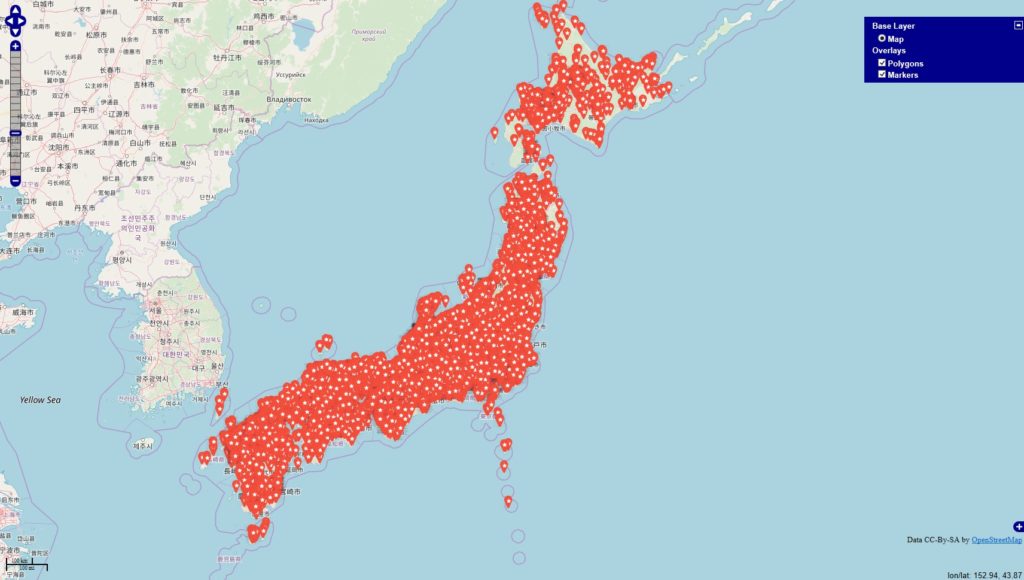

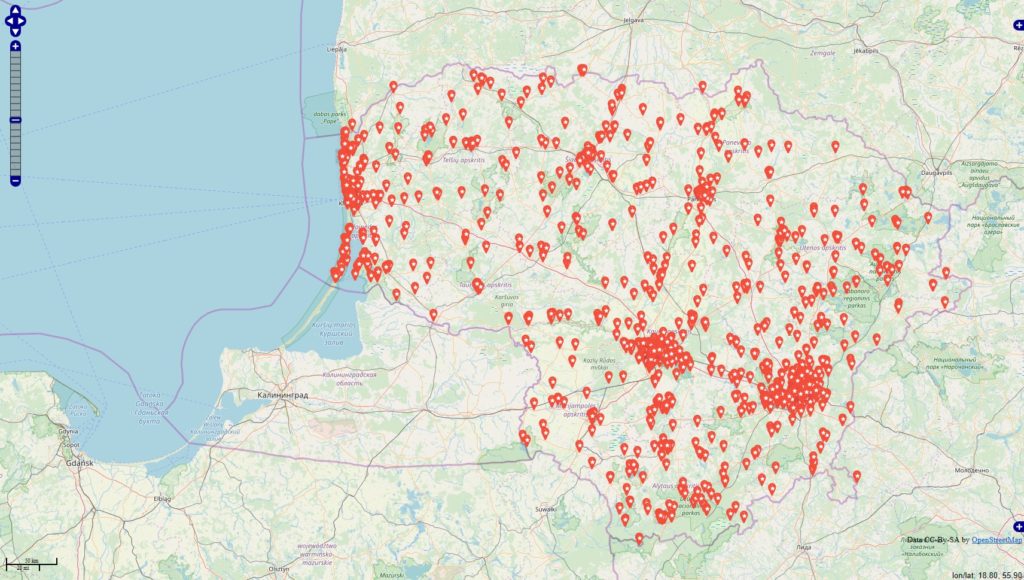

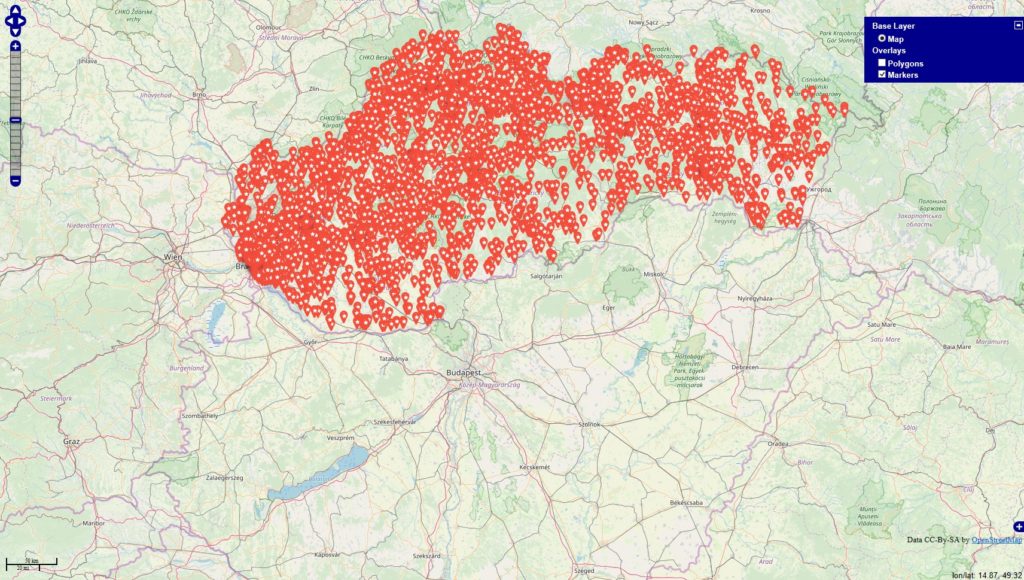

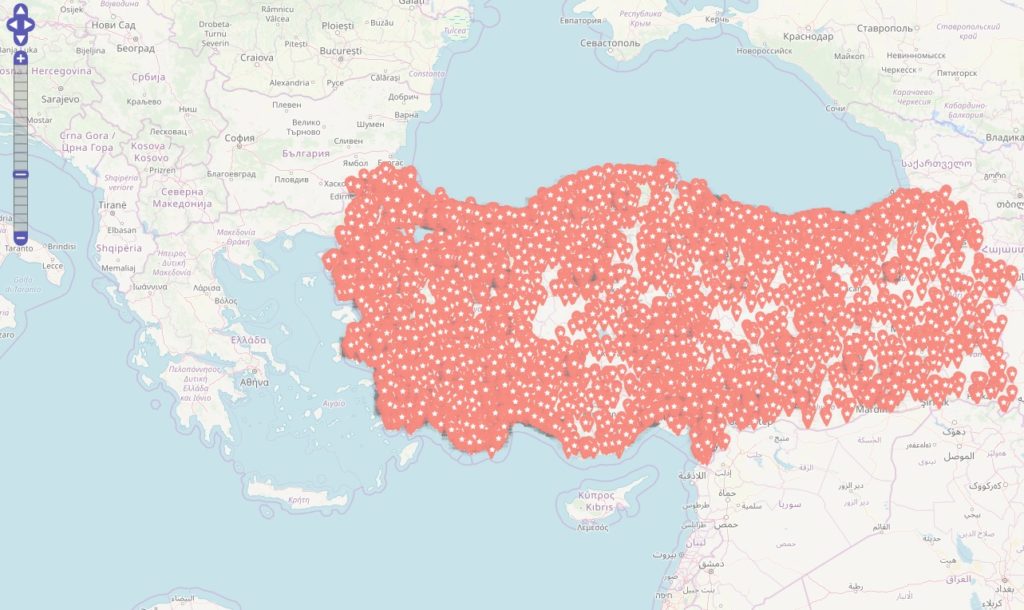

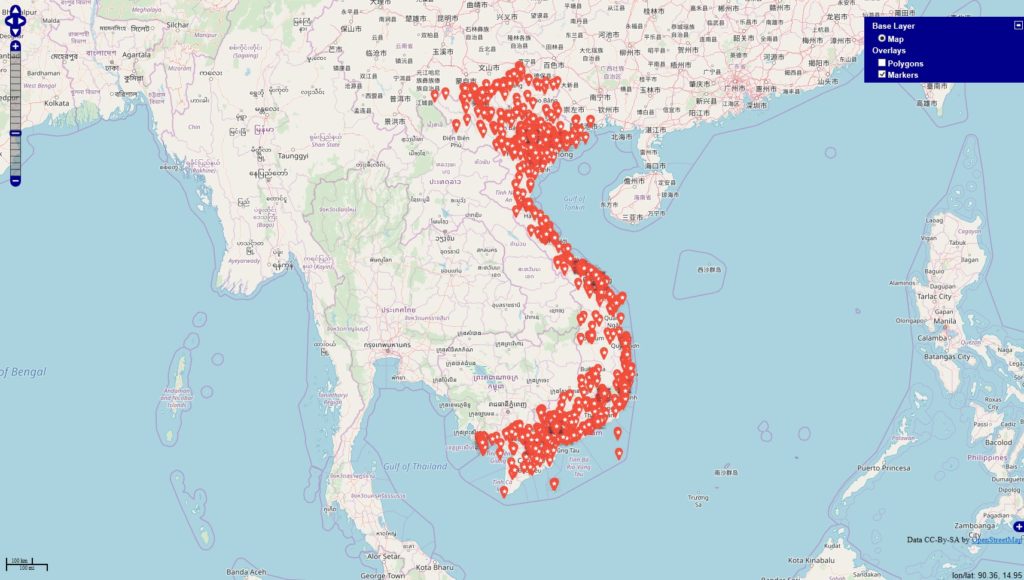

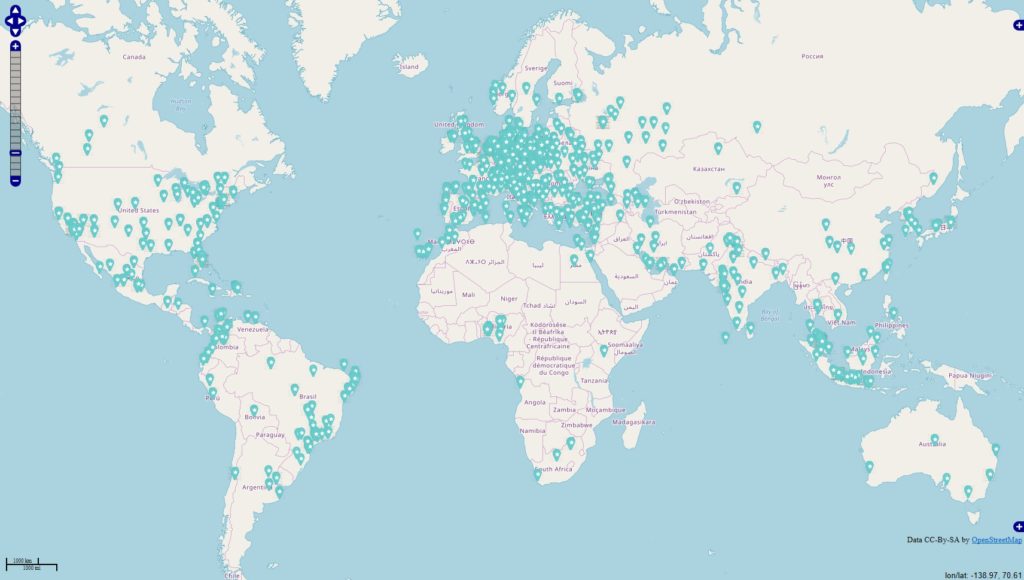

380.723 Locations

2.674.339 Zeitstempel

Datenauszüge (unverschlüsselt)

(1) Auflistung Tagwolken und deren Locations

Datei: exp_urlaub_tag_loc.zip

Dateivolumen: ZIP->339MB, Entpackt->1.6GB

(2) Auflistung der Locations und Aufsummierung der Likes JE Location

Datei: exp_urlaub_like_locs.zip

Dateivolumen: ZIP->13MB, Entpackt->42MB

(3) Auflistung Tagwolken (ungefiltert!) und deren Likes

Datei: exp_urlaub_tag_likes.zip

Dateivolumen: ZIP->168MB, Entpackt->600MB

(4) Auflistung der Locations + Postingzeitstempel + Likes

Datei: exp_urlaub_loc_time_likes.zip

Dateivolumen: ZIP->52MB, Entpackt->265MB

(5) Auflistung der Locations + Aufsummierung der Postings

Datei: exp_urlaub_postings_locs.zip

Dateivolumen: ZIP->12MB, Entpackt->42MB

(6) Auflistung der Tagwolken + Aufsummierung der User, welche die Wolken verwendeten

Datei: exp_urlaub_tags_user.zip

Dateivolumen: ZIP->333MB, Entpackt->1.5GB

(7) Auflistung der Locations + Aufsummierung der User, welche an den Locations aktiv waren

Datei: exp_urlaub_loc_user.zip

Dateivolumen: ZIP->13MB, Entpackt->41MB

Die aufgelisteten Datenauszüge geben einen ersten und sehr guten Überblick.

Im Bezug zu den erfassten Datensätzen sind weitere Nachforschungen die Beantwortung hochfaszinierender Fragen, wie:

(a) Wieviele User schreiben in welchem Zeitfenster über den Urlaub an welchen Orten?

(b) Welche Orte werden an Hotspots von welchen Usergruppen besucht und was wird da geschrieben?

(c) Welche User / Usergruppen neigen zur Trendbildung an welchen Orten und / oder zu welchen Tags (Themen, Themenwelten)?

(d) Welche Orte werden zu welchen Zeitfenstern|Jahreszeiten|Monaten besonders stark frequentiert und was wird da geschrieben?

möglich.

Die Anwendungsszenarien sind vielfältig. Ich denke an die folgenden Punkte:

-> Influenceraccountanalysen

-> Schnittstellen zu Socialmediastrategien inkl. Hashtag- und Postzeitplanungen

-> Schnittstellen zu div. Textanalysetools mit Anbindung an WDF*IDF / KWD-Analysen

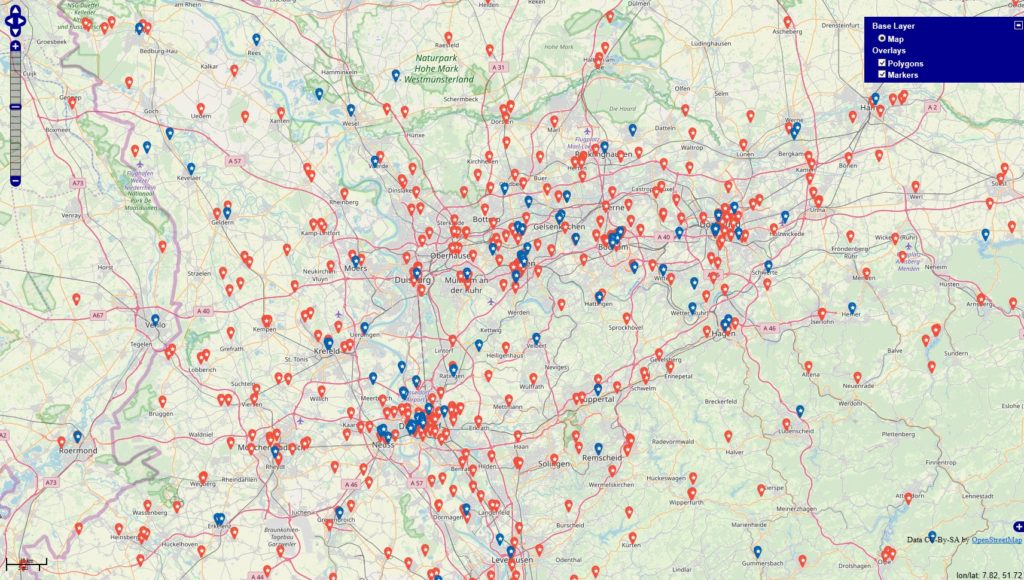

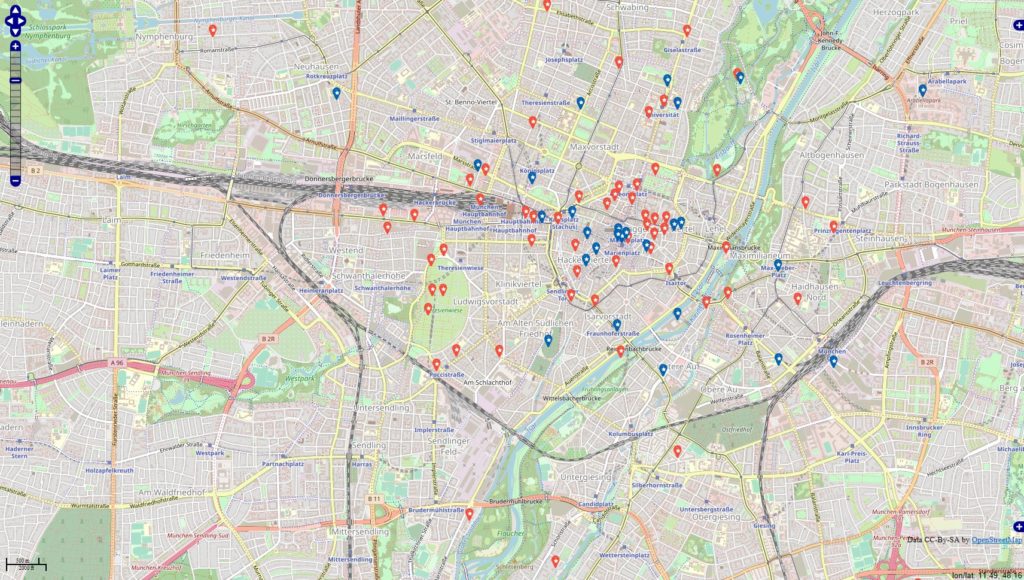

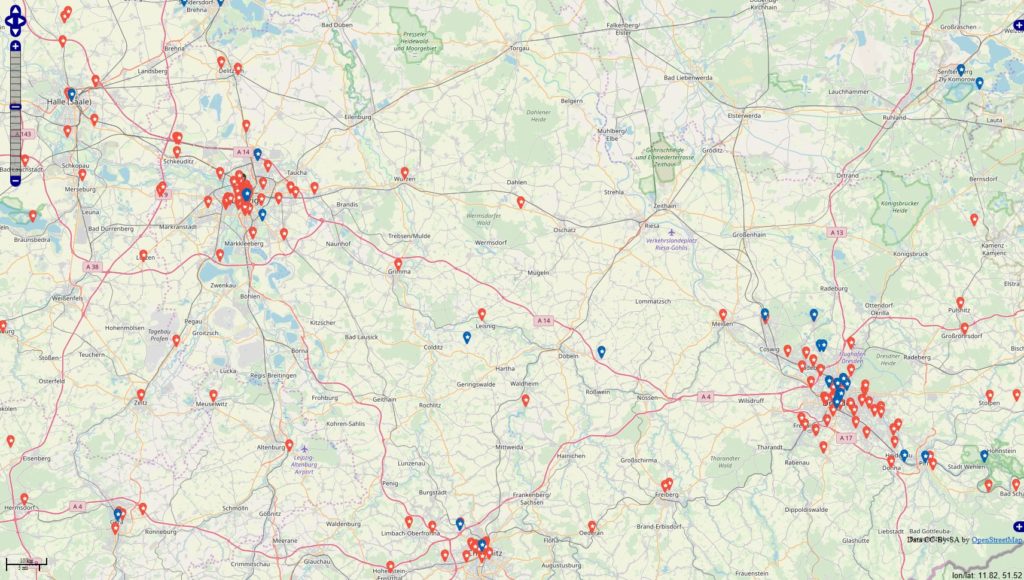

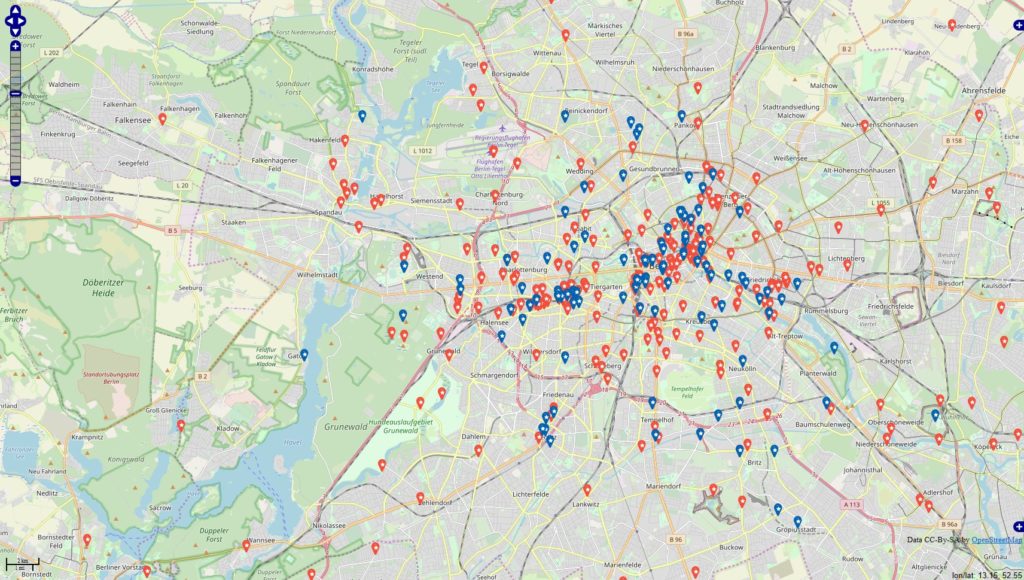

-> gezielte Steuerung von ortsbezogenen Werbeanzeigen|Flyeraktionen|Plakataktionen|sonst.Promomaßnahmen

-> Gegenprobe auf die üblichen Auswertungstools aus der Socialmedia

-> gezielte Steuerung von ortsbezogenen Werbeanzeigen in den Suchmaschinen, den Socialmedia

Interesse am Austausch? Fragen? Anfragen?

Konkretes Projektangebot?

Ich freue mich auf Rückmeldung unter der eMail: office(at)pontipix.de