Vor ein paar Tagen nahm ich mir etwas Weiterbildungszeit und sichtete diverse WWW-Marketing-Wochenabschlussbeiträge. Zur Info: diese besondere Art der Blogbeiträge beschreibt meistens eine Wochenzusammenfassung an besonders faszinierenden Links und externen Beiträgen. Aus logischen Gründen stand aktuell meistens Facebook und / oder die generelle Arbeit mit den Socialmedia im Fokus und ich wurde aufmerksam / munter, als ich das Dokument „Pinterest, Google, & Instagram big winners as Facebook share of visits falls 8% in 2017“ von Shareaholic da gesehen hatte und hier ist eine Klischeesituation aufgefallen:

[1] Eine Autorität veröffentlicht Beobachtungen

[2] Eine Subautorität nimmt die Beobachtungen daher, ergänzt diese um einige Anmerkungen

[3] Unfassbar viele Dienstleister_innen nehmen die Inhalte aus [2], um diverse Existenzberechtigungen herbei zu argumentieren und sog. „hochwertigen Content“ zu produzieren.

Der gemeinsame Nenner zwischen [2] und [3] ist hier – ganz im Sinne der Klischees – das bewusste Nicht-Hinterfragen der Thesen aus [1], da man es ja mit einer wahnsinnig anerkannten Autorität zu tun hat. Ich erkenne jedenfalls keinerlei Logik in dieser faszinierenden Gangart und Branchenautoritäten müssen sich jedezeit hinterfragen und fachlich kritisieren lassen. Aus meiner Perspektive generiert sich genau aus diesem Merkmal die Berechtigung des Labels „Autorität“ und es ist mir schleierhaft, warum gefühlt sämtliche Autoritäten der Marketingbranchen den fachlichen Konflikt meiden.

Wie auch immer und zurück zum Shareaholic-Artikel kommend.

Ich unterstelle Shareaholic aus sehr guten Gründen eine gewisse Grundkompetenz bzgl. der Aus- und Bewertung von Socialsignals, nur befinden sich im Beitrag diverse Lücken:

[1] Keine Offenlegung der analysierten Seiten.

[2] Keine Offenlegung der Länder und Zielgruppen zu den analysierten Seiten.

[3] Keinerlei Offenlegung der zeitlichen Entwicklung der Signals / Socialbewegungen über den kompletten Zeitraum von 2017.

[4] Keinerlei Offenlegung der Datenerhebungsmethoden.

Gerade der 4. Punkt wirkt auf mich – vorsichtig formuliert (!) – mehr als verwirrend und ich frage mich, warum den DACH-Kolleg_innen nicht aufgefallen ist, dass Instagram schlichtweg keinerlei Möglichkeiten zur Analyse von Traffic von externen (also: nicht selbst betreuten!!!) Seiten und Projekten liefert: es existiert keine einzige Möglichkeit, mit Schnittstellen / API-Endpoints den Traffic von völlig unbetreuten Accounts zu deren Webseiten zu erfassen. Da frage ich mich: Wie hat das Shareaholic geschafft und wo genau befindet sich da die Dokumentation? Diese sehe ich nicht und Querchecks via Google und diverse „Nerd“-foren ergab keinesfalls eine Problemlösung.

Es bleibt also folgende Frage offen: Warum bewirbt man mit völlig intransparenten Datenerhebungen ein Socialmedium zum Zwecke der Trafficgenerierungsansätze? Ich sehe hier keinerlei Logik oder sogar Gesprächsgrundlage für diese oder jene Projekte.

Genau diese Problematik beschäftigte mich die letzten 2 Tage und das Ergebnis entsprechender Gedankengänge ist:

[1] Instagram

Der Traffic via Instagram lässt sich definitiv nicht sauber monitoren, wenn keinerlei Zugriff auf eine hinreichend große Accountmasse (Hier: alle Themen, Länder, Branchen etc.) besteht. Man kann also nur mit Hilfe der Indikatoren hier Analysen anstellen und ich wage die Formulierung folgender Thesen:

(a) Der Traffic ist hoch, wenn möglichst viele Interaktionen auf den Postings der jeweiligen Accounts identifizierbar sind, wobei hier zwischen Botgesteuert und „Organisch“ zu unterscheiden ist.

Quellen:

Beiträge aus „Interaktionenprojekt“

InstagramAPI (Endpoint -> Likes)

InstagramAPI (Endpoint -> Comment -> Get)

(b) Der Traffic kann hoch werden / sich gut entwickeln / ist hoch, wenn die Postings der jeweiligen Accounts entsprechend „mächtige“ Hashtags verwerten.

Quellen:

Beiträge aus „Hashtagprojekt“

Datenbanken zu „Hashtagprojekt“

InstagramAPI (Endpoint -> GetTag)

Werden über die bekannten und dokumentierten API-Endpoints bspw. zu Instagram die notwendigen Daten erhoben, stellt man sehr schnell etwas „Lustiges“ fest:

Die Datenmassen können zwar extrem umfangreich sein, jedoch bilden Diese immer einen recht kleinen Moment aus dem Universum von Instagram ab. Sie lassen sich maximal im Rahmen der Datenbankinhalte verwerten und können keinesfalls Aufschluss über unbekannte Themen und Untersuchungsobjekte liefern. Dann weiter: die Verwertung dieser technischen Schnittstellen zeigt ab einem gewissen Punkt die Begrenztheit, weil eben diese Endpoints nur eine begrenzte Menge an Abfragen zulassen. Instagram ist hier recht liberal oder „großzügig“, andere Socialmedia jedoch nicht (siehe: Twitter und die Retweet / Tweetzählproblematik).

Fazit zu Instgram:

Absolute Aussagen zu „Traffic“ im Vergleich zu den anderen Socialmedia lassen sich nicht sauber generieren, man arbeitet da mit „Vermutungen“ und die Sauberkeit eben dieser Vermutungen / Prognosen hängt ab von:

– Offenlegung der Erhebungsverfahren

– Gegenprobe via API-Endpoints

– Menge der erhobenen Daten aus „API-Endpoints“ inkl. deren inhaltlichen Breite

Diese Sachen sehe ich weder im o.g. Report, noch in den Szenecontentmarketingaktivitäten.

[Andere Socialmedia außerhalb von Instagram]

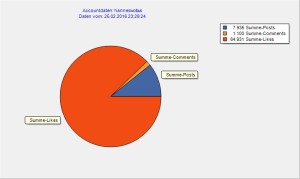

Am 6.12.2013 fand ich Gelegenheit, ein Projekt fertig zu stellen. Dieses ist auch Bestandteil unserer Monitoringaktivitäten und begutachtet die Socialsignalentwicklungen aus Facebook, Twitter und Pinterest. Früher empfand ich noch die Notwendigkeit, Google-Plus zu beobachten und die entsprechende Funktion wurde im Laufe der Jahre eingestellt, da besagtes Medium eine extrem untergeordnete Rolle spielt. Die Kernidee hinter dem Projekt entstand eigentlich bereits in den Jahren 2010-2011, als wir – aus einem Zufall heraus – die Socialmedia (damals primär Twitter und Friendfeed) als spannendes Promomittel entdeckten und hierüber geradezu euphorisierende Rankingeffekte (einhergehend mit Traffic und Umsatz) produzieren konnten. Es war damals für alle Beteiligten absolut sichtbar und klar, dass selbstverständlich Traffic über die verwerteten Socials organisierbar IST und aus dieser Beobachtung leitete ich damals (!) folgende These ab:

Der Traffic via Twitter, Facebook u. anderen ist von der Sichtbarkeit abhängig und die Sichtbarkeit der der Postings ist abhängig von den Interaktionen auf dem Posting.

Die Thesenverifikation lässt sich via Quercheck auf die Interaktionszähltools und entsprechende APIs realisieren, wobei man hier selbstverständlich in regelmäßigen Abständen Prüfungen durchzuziehen hat.

Twitter: https://opensharecount.com/

Pinterest: https://api.pinterest.com/v1/urls/count.json?callback%20&url=deineurl.org

Facebook: https://www.kickstartcommerce.com/use-facebook-graph-api-get-count-url-likes-shares-comments.html

Obwohl ich dazu neige, bspw. aus den Socialsignalszahlen generelle Trafficprognosen abzuleiten, neigt die liebe Anne Lehmann hier zu einer gewissen „Erbsenzählerei“ und sie zwang mich irgendwann dazu, eine weitere Gegenprobe funktion zu suchen. Diese fand ich in dem Ansatz über die Bit.ly-API und unser Monitoringwerkzeug erfasst diese Zahlen parallel zu den Daten aus den genannten Interaktions/Signalszähler. Hierbei muss natürlich beachtet werden, dass ein (relativ) sauberes Trafficmonitoring nur dann funktioniert oder „aufgeht“, wenn die begutachteten Projekte eben auch mit Bit.ly-URLs arbeiten.

Fazit aus meiner „Arie“.

-> Manche oder viele Autoritäten verdienen zwar einen gewissen Vorschuss an Vertrauen, jedoch muss die Autorität hinterfragbar sein und diese Vorraussetzung ist nicht gegeben, wenn Datenerhebungswege oder Grundlagen dieser oder jener Thesen nicht offen gelegt werden.

-> Der kritiklose Umgang mit „Studien“ und / oder Autoritäten birgt die Gefahr von falschen und gefährlichen Strategien im Onlinemarketing.

Fragen? Anmerkungen?